هوش مصنوعی کوانتومی چیست؟ در این مقاله سعی شده اطلاعاتی کامل درباره پروژه جدید و مشترک دو غول دنیای تکنولوژی، یعنی سازمان ناسا و شرکت گوگل گردآوری گردد که تلفیقی از هوش مصنوعی کوانتومی و کامپیوترهای کوانتومی است. پروژه ای که در آن، این دو شرکت بزرگ به همراه شرکت D-Wave، اقدام به ساخت و هوشمند سازی کامپیوترهایی با پردازشگرهای کوانتومی کرده اند.

گوگل و ناسا در این پروژه اهداف مشترکی را دنبال نمی کنند، چرا که گوگل بیشتر به دنبال کمک به علم پزشکی و ناسا به دنبال حل مشکلات محاسباتی خود در پروژه های فضایی است، اما در حال حاضر هر دو شرکت همکاری مشترکی در محل آزمایشگاه کوانتومی ناسا در کالیفرنیا دارند. می توان گفت این پروژه هنوز مراحل اولیه خود را طی می کند، اما داشتن اطلاعاتی در این باره و میزان پیشرفت علم، می تواند بسیار جذاب و شگفت انگیز باشد!

در این مطلب سعی شده است مطالبی مختصر و کاربردی درباره علم فیزیک کوانتوم، تاریخچه ساخت کامپیوترهای کوانتومی و استفاده و کاربرد این کامپیوترها با استفاده از هوش مصنوعی در پژوهش های ناسا تهیه و ارائه گردد. شایان ذکر است این مطلب درباره پیشرفت تکنولوژی و ساخت ابزاری در جهت بهترین استفاده از علم هوش مصنوعی و شبیه سازی است و اشاره ای به مباحث تئوری هوش مصنوعی ندارد.

فیزیک کوانتوم دقیقاً چیست؟

آقای ریچارد فینمن (۱۹۸۸-۱۹۱۸) یکی از بنیان گذاران علم فیزیک کوانتوم می گوید اگر فکر می کنید فیزیک کوانتوم را درک کرده اید، پس هنوز معنای آن را نمی دانید. اما اصلا فیزیک کوانتوم چیست ؟

در واقع با استفاده از فیزیک کوانتوم می توان محاسباتی دقیقی بر روی ذرات در مقیاس اتمی و زیراتمی انجام داد، در حالی که با فیزیک کلاسیک معمولا نمی توان توصیف کاملی از پدیده ها ارائه کرد.

بهتر است برای درک بهتر موضوع فیزیک کوانتوم ، یک مثال ساده و البته بسیار مشهور زد :

اگر قرار بود مکانیک نیوتنی و الکترومغناطیس کلاسیک بر رفتار یک اتم حاکم باشند، الکترونها بایستی به سرعت به سمت هسته اتم حرکت و بر روی آن سقوط می کردند و در نتیجه اتم ها ناپایدار میشدند. ولی در دنیای واقعی، الکترونها در نواحی خاصی دور اتمها باقی میمانند و چنین سقوطی مشاهده نمی شود. تلاش اولیه برای حل این تناقض توسط نیلس بور، زمانی انجام شد که فرضه خود را مبنی بر وجود مدارهای مانا ارائه کرد و موفقیت هایی هم در توصیف طیف اتم هیدروژن داشت.

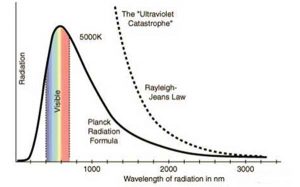

در اواخر قرن نوزدهم و اوایل قرن بیستم پدیده دیگری که در مسیر حل مشکلات فیزیک کلاسیک در مسائلی با مقیاس اتم جلب توجه میکرد، مطالعه رفتار امواج الکترومغناطیسی مانند نور در برهمکنش با ماده بودند. ماکس پلانک در سال ۱۹۰۰ هنگام مطالعه بر روی تابش جسم سیاه پیشنهاد کرد که برای توصیف صحیح مساله تابش جسم سیاه، می توان انرژی این امواج را به شکل بستههای کوچکی ( کوانتا یا کوانتوم ) در نظر گرفت. آلبرت انیشتین از این فکر بهره برد و نشان داد که امواجی مثل نور را میتوان با ذرهای به نام “فوتون” که انرژی آن به بسامد موج بستگی دارد، توصیف کرد.

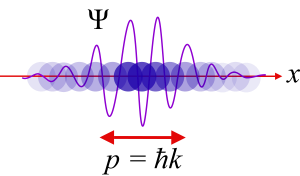

در ادامه، با نظریه “دوبروی”، مبنی بر امکان توصیف حرکت ذرات بوسیله امواج، این نظریهها به دیدگاهی به نام دوگانگی موج-ذره برای ذرات و امواج الکترومغناطیسی منجر شدند که مطابق آن، ذرات، هم رفتار موجی و ذره ای را از خود نشان می دهند.

هوش مصنوعی

تابش جسم سیاه (فاجعه فرابنفش)

ماکسول (۱۸۷۹-۱۸۳۱) نور را به صورت یک موج الکترومغناطیس در نظر گرفته بود. از این رو، همه فکر می کردند نور یک پدیدهی موجی است و ایدهی «مولکولِ نور»، در اواخر قرن نوزدهم، یک لطیفهی خلاقانه محسوب میشد!

به هر حال، دست سرنوشت و آزمایش جسم سیاه، یک علامت سؤال بزرگ برای ماهیت موجی نور در برداشت که به « فاجعه فرابنفش » مشهور شد: یک محفظهی بسته و تخلیهشده را که روزنهی کوچکی در دیوارهی آن وجود دارد، در کوره ای با دمای یکنواخت قرار دهید و آنقدر صبر کنید تا آنکه تمام اجزا به دمای یکسان (تعادل گرمایی) برسند. وقتی دما به اندازه کافی بالا برود، نور مرئی از روزنهی محفظه خارج میشود، مثل سرخ و سفید شدن آهن گداخته در آتش آهنگری.

در تعادل گرمایی، این محفظه دارای یک انرژی تابشی است که آن را در تعادل تابشی – گرمایی با دیواره ها نگه میدارد. به چنین محفظهای «جسم سیاه» میگوییم. یعنی اگر روزنه به اندازهی کافی کوچک باشد و پرتو نوری وارد محفظه شود، گیر می افتد و نمی تواند بیرون بیاید.

هوش مصنوعی

تئوری کامپیوتر و ماشین های کوانتومی

- رویای محاسبات مسائل در اشکال گوناگون

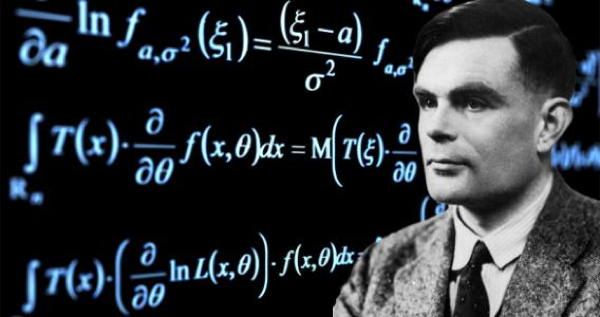

تاریخچه هوش مصنوعی را از آنجایی پی می گیریم که انسان رویای محاسبات ماشینی را در سر خود پرورش داد. رویای محاسبات ماشینی ، یا ماشینی که بتواند مسائل را در اشکال گوناگون حل کند کمتر از دو قرن است که زندگی بشر را به طور جدی درگیر خود کرده است. اگر از ابزارهایی نظیر چرتکه و برخی تلاشهای پراکنده دیگر در این زمینه بگذریم، شاید بهترین شروع را بتوان به تلاشهای «چارلز بابیج» و «بلز پاسکال» با ساخت ماشین محاسبه مکانیکی آن ها نسبت داد. با گذشت زمان و تا ابتدای قرن بیستم تلاش های زیادی جهت بهبود ماشین محاسبه مکانیکی صورت گرفت که همه آنها بر پایه ریاضیات دهدهی (decimal) بود، یعنی این ماشینها محاسبات را همان طور که ما روی کاغذ انجام میدهیم انجام میدادند. در اوایل قرن بیستم، تحول بزرگی در محاسبات ماشینی رخ داد؛ یعنی زمانی که الگوریتم و مفهوم فرآیندهای الگوریتمی (algorithmic processes) به سرعت در ریاضیات و به تدریج در سایر علوم رشد کرد.

جدایی ریاضیات از کامپیوتر

ریاضیدان ها شروع به معرفی سیستمهای جدیدی برای پیادهسازی الگوریتمی کلی کردند که در نتیجه آن، سیستمهای انتزاعی محاسباتی بوجود آمدند. در این میان سهم برخی بیشتر از سایرین بود.

آنچه امروزه دانش کامپیوتر و یا الکترونیک دیجیتال نامیده می شود، مدیون کار ریاضیدان برجسته انگلیسی، «آلن تورینگ» (Alan Turing) است. او مدلی ریاضی را ابداع کرد که آنرا ماشین تورینگ مینامیم و اساس تکنولوژی دیجیتال در تمام سطوح آن است. وی با پیشنهاد استفاده از سیستم دودویی برای محاسبات به جای سیستم عدد نویسی دهدهی که تا آن زمان در ماشینهای مکانیکی مرسوم بود، انقلابی عظیم در این زمینه بوجود آورد. شاید بتوان آلن تورینگ را نیروی محرکه ای برای آینده و شکل گیری هوش مصنوعی دانست؛ اما بعد از نظریه طلایی تورینگ، دیری نپایید که «جان فون نویمان» یکی دیگر از نظریه پردازان بزرگ قرن بیستم موفق شد ماشین محاسبه گری را بر پایه طرح تورینگ و با استفاده از قطعات و مدارات الکترونیکی ابتدایی بسازد. به این ترتیب کم کم دانش کامپیوتر از ریاضیات جدا شد و امروزه خود زمینهای مستقل و در تعامل با سایر علوم به شمار میرود. گیت های پیشرفته، مدارات ابر مجتمع، منابع ذخیره و بازیابی بسیار حجیم و کوچک، افزایش تعداد عمل در واحد زمان و غیره از مهمترین این پیشرفت ها در بخش سختافزاری محسوب میشوند.

در ۱۹۶۵ «گوردون مور» اظهار کرد که توان کامپیوترها، در هر دو سال دو برابر خواهد شد. در تمام این سال ها، تلاش عمده در جهت افزایش قدرت و سرعت عملیاتی در کنار کوچک سازی زیر ساختها و اجزای بنیادی بوده است. نظریه مور در دهههای ۶۰ و ۷۰ میلادی تقریباً درست بود. اما از ابتدای دهه ۸۰ میلادی و با سرعت گرفتن این پیشرفت ها، شبهات و پرسشهایی در محافل علمی مطرح شد، مبنی بر اینکه “این کوچک سازی ها تا کجا میتوانند ادامه پیدا کنند؟” کوچک کردن ترانزیستورها و مجتمع کردن آنها در فضای کمتر نمیتواند تا ابد ادامه داشته باشد زیرا در حدود ابعاد نانو متری اثرات کوانتومی از قبیل تونل زنی الکترونی بروز میکنند. گرچه همیشه تکنولوژی چندین گام بزرگ از نظریه عقب است، بسیاری از دانشمندان در زمینههای مختلف به فکر رفع این مشکل تا زمان رشد فناوری به حد مورد نظر افتادند.

به این ترتیب بود که برای نخستین بار در سال ۱۹۸۲ «ریچارد فینمن» معلم بزرگ فیزیک و برنده جایزه نوبل، پیشنهاد کرد که باید محاسبات را از دنیای دیجیتال وارد دنیای جدیدی به نام کوانتوم کرد که بسیار متفاوت از قبلی است و نه تنها مشکلات گذشته و محدودیتهای موجود را بر طرف میسازد، بلکه افقهای جدیدی را نیز به این مجموعه اضافه میکند. این پیشنهاد تا اوایل دهه ۹۰ میلادی مورد توجه جدی قرار نگرفت تا بالاخره در ۱۹۹۴ «پیتر شور» از آزمایشگاه AT&T در آمریکا نخستین گام را برای محقق کردن این آرزو برداشت. به این ترتیب ارتباط نوینی بین نظریه اطلاعات و مکانیک کوانتومی شروع به شکل گیری کرد که امروزه آنرا محاسبات کوانتومی یا محاسبات نانو متری (nano computing) می نامیم.

در واقع هدف محاسبات کوانتومی ، یافتن روش هایی برای طراحی مجدد ادوات شناخته شده محاسبات (مانند گیتها و ترانزیستورها) به گونه ای است که بتوانند تحت اثرات کوانتومی کار کنند که در محدوده ابعاد نانو متری و کوچکتر بروز میکنند.

نوع اتمهای به کار رفته، نحوه چینش اتمها، چگونگی ایجاد سلول نمایش یافته (معماری سلولی) و چند ویژگی دیگر خصوصیات معادل با گیتهای به کار رفته در نمونه دیجیتال هستند. یک راه نظری برای پیادهسازی سلول در این طرح، استفاده از «نقاط کوانتومی» (quantum dots) یا چیزی است که در زبان مکانیک کوانتومی آنرا «اتم مصنوعی» مینامیم.

- محاسبات کوانتومی

کامپیوتر تنها بخشی از دنیایی است که ما آن را دنیای دیجیتالی مینامیم. پردازش ماشینی اطلاعات، در هر شکلی، بر مبنای دیجیتال و محاسبات کلاسیک انجام می شود. اما کمتر از یک دهه است که روش بهتر و قدرتمندتر دیگری برای پردازش اطلاعات پیش روی ما قرار گرفته است که بر اساس مکانیک کوانتومی میباشد.

این روش جدید با ویژگی هایی همراه است که آن را از محاسبات کلاسیک بسیار متمایز میکند. گرچه محاسبات دانشی است که اساس تولد آن در ریاضیات بود، اما کامپیوترها سیستمهایی فیزیکی هستند و فیزیک در آینده این دانش، نقش تعیین کنندهای خواهد داشت. البته وجود تفاوت بین این دو به معنای حذف یکی و جایگزینی دیگری نیست. به قول «نیلس بور» گاهی ممکن است خلاف یک حقیقت انکار ناپذیر منجر به حقیقت انکار ناپذیر دیگری شود. بنابراین محاسبات کوانتومی را به عنوان یک زمینه و روش جدید و بسیار کارآمد مطرح میکنیم.

وجود چند پدیده مهم که مختص فیزیک کوانتومی است، آن را از دنیای کلاسیک جدا میکند. این پدیده ها عبارتند از: برهم نهی(superposition)، تداخل (interference Entanglement,) عدم موجبیت (non determinism)، نا جای گزیدگی (non locality) و تکثیر ناپذیری (non clonability). برای بررسی اثرات این پدیدهها در این روش جدید، لازم است که ابتدا واحد اطلاعات کوانتومی را معرفی کنیم:

هر سیستم محاسباتی دارای یک پایه اطلاعاتی است که نماینده کوچکترین میزان اطلاعات قابل نمایش، چه پردازش شده و چه خام است. در محاسبات کلاسیک این واحد ساختاری را بیت مینامیم که گزیده واژه «عدد دودویی» است زیرا میتواند تنها یکی از دو رقم مجاز صفر و یک را در خود نگه دارد. به عبارت دیگر هر یک از ارقام یاد شده در محاسبات کلاسیک، کوچکترین میزان اطلاعات قابل نمایش محسوب میشوند. پس سیستمهایی هم که برای این مدل وجود دارند باید بتوانند به نوعی این مفهوم را عرضه کنند. در محاسبات کوانتومی هم چنین پایهای معرفی میشود که آنرا کیوبیت (qubit) یا بیت کوانتومی مینامیم. هر بیت کوانتومی یا کیوبیت عبارت است از یک سیستم دودویی که میتواند دو حالت مجزا داشته باشد. به عبارت فنی تر، کیوبیت یک سیستم دو بعدی کوانتومی با دوپایه به شکل ^ است.

برای مثال بیت باید در هر لحظه یا نشان دهنده صفر و یا نشان دهنده یک باشد، مانند یک چراغ که میتوان در آن، حالت روشن را برابر یک و خاموش را برابر صفر فرض کرد. یک کیوبیت به بیت کلاسیک شباهتهایی دارد، اما در کل بسیار متفاوت است. اختلاف این است که در حالی که یک بیت کلاسیک باید در هر لحظه یا در حالت صفر و یا در حالت یک باشد اما یک کیوبیت می تواند در حالت صفر، یک هم باشد.

- ساخت کامپیوترهای کوانتومی

موسسه D-Wave یک موسسه کانادایی است که توسط آقای ورن برانل در سال ۱۹۹۰ تأسیس شد و از ابتدا با هدف تولید و حرکت در عرصه کامپیوترهای کوانتومی شروع به کار کرد. ساخت اولین کامپیوتر کوانتومی این شرکت در سال ۲۰۱۱ به پایان رسید و با نام D-Wave One به جهانیان معرفی شد. پردازشگر این کامپیوتر کوانتومی ۱۲۸ کیوبیت است که معادل آن به بیت کلاسیک معادل ۲۱۲۸ است. هدف اولیه و کلی از تولید و ساخت کامپیوترهای کوانتومی استفاده برای شبیه سازی، هوش مصنوعی، بهینه سازی و مخصوصا یادگیری ماشین ها است. اولین کامپیوتر کوانتومی ساخت شرکت D-Wave معادل ده میلیون دلار در سال ۲۰۱۱ قیمت داشت.

چندی پیش و در سال ۲۰۱۳ دومین کامپیوتر کوانتومی این شرکت به نام D-Wave Two ساخته شده. این کامپیوتر توسط سازمان ناسا و شرکت گوگل خریداری شد تا این دو شرکت با همکاری D-Wave بتوانند به اهداف خود در زمینه هوش مصنوعی و شبیه سازی با استفاده از پردازش کوانتومی نزدیک شوند. قدرت پردازش D-Wave Two در ابتدا معادل ۵۱۲ کیوبیت بوده که قرار است همزمان با انجام تحقیقات ناسا و گوگل در آزمایشگاه ناسا این مقدار تا ۲۰۴۸ کیوبیت افزایش پیدا کند. سرانجام در سال ۲۰۱۷ و در ماه ژانویه مدل جدید ۲۰۰۰Q پا به عرصه گذاشت، قدرت پردازش آن ۲۰۰۰ کوبیتز بود که حدوداً دو برابر بیشتر از مدل D-Wave Two است.

هوش مصنوعی

وِرن براونِل مدیر عامل کمپانی D-Wave در این رابطه گفت:

«این سومین نسل از فناوری های «دی-وِیو» است که در مرکز تحقیقاتی Ames مستقر می شود. ما خوشحاgیم که گوگل، ناسا و USRA برای قدرت پردازشی افزایش یافته در آخرین نسل از تکنولوژی های ما، یعنی سیستم D-Wave 2000Q ارزش قائل شده و از آن برای برنامه های حیاتی خود استفاده می کنند.»

لازم به ذکر است در حال حاضر معایب پردازش های کوانتومی به شرایط محیطی بسیار سخت بر می گردد. پردازنده باید در محفظه ای با فشار ده میلیارد مرتبه کمتر از اتمسفر زمین قرار داشته باشد. همچنین کامپیوتر ۲۰۰۰Q برای آنکه بیشترین بازده را داشته باشد لازم است در فضایی با دمای ۱۸۰ بار سردتر از فضا یا به عبارتی ۰٫۰۱۵ درجه بیشتر از صفر مطلق قرار داشته باشد.

پژوهش های ناسا

آزمایشگاه هوش مصنوعی کوانتومی ناسا جهت پشتیبانی و انجام مطالعات و تحقیقاتی اساسی و تجربی که میتوانند منجر به بدست آوردن نتایجی مؤثر در پیشرفت کامپیوترهای کوانتومی بنا شده است. زمینه های پژوهش این آزمایشگاه در حال حاضر به شرح زیر است:

الگوریتم ها

یکی از مشکلات حل نشده اصلی در این مرکز، بدست آوردن الگوریتم های اکتشافی کوانتومی کارآمد، جهت حل مشکلات اساسی در زمینه بهینه سازی ترکیب مسائل است که تا به امروز در بسیاری از مأموریت های ناسا و در بخش اصلی و مرکزی آن کشف شده است. الگوریتمهای اکتشافی کلاسیک، جهت حل کردن و یا بدست آوردن راه حال های تقریبی برای رفع مشکلات سخت چنین نمونه هایی، سالها توسعه داده شده اند، اما هنوز هم توسعه این الگوریتمها یکی از بخشهای اصلی این مرکز تحقیقاتی است.

میزان تأثیرگذاری و اثر بخشی این روش ها با اجرای آن ها بر روی مجموعه ای از مشکلات جهت حل آن ها مشخص میشود. حال انجام این آزمایش ها برای الگوریتم های کوانتومی نیاز به وجود سخت افزاری کوانتومی دارد. چندماه پیش وقتی دسترسی به سخت افزار کوانتومی فراهم گردید تیم هوش مصنوعی کوانتومی ناسا با استفاده از ماشین کوانتومی D-Wave Two طراحی و ارزیابی روشهای کوانتومی جهت رفع مشکلات بهینه سازی مسائل ترکیبی را آغاز کرد.

تلاش های اولیه، بیشتر جهت بررسی و آنالیز تئوری و عملی شیوه ای به نام Quantum Annealing برای حل مشکلات این بهینه سازی ها است. همچنین کار این تیم شامل توسعه الگوریتم هوش مصنوعی کوانتومی، بدست آوردن تکنیک آماده سازی سخت افزار و تجزیه و تحلیل مشکلات و کشف الگوریتم هایی است که به صورت کوانتومی و کلاسیک ( ترکیبی/ Hybrid) هستند.

Quantum Annealing

نام دیگر این شیوه محاسباتی “بی در رو” است. الگوریتم های محاسبات کلاسیک در حل مشکلات بهینه سازی، دارای مشکلاتی هستند. برای مثال توپی بزرگ را در نظر بگیرید که در قله ای قرار دارد و برای رسیدن به پایین دره بر روی قسمتهای مختلف کوه جهش میکند. بررسی تعداد زیاد حرکت برای رسیدن توپ به دره در صورتی که ارتفاع قله زیاد باشد امکان بدست آوردن بهترین مسیر برای پایین آمدن توپ از کوه با استفاده از فیزیک کلاسیک را غیر ممکن می کند. اما با شیوه Quantum Annealing ، خاصیت کوانتومی انطباق (مثل داشتن همزمان صفر و یک در یک کیوبیت) به توپ اجازه می دهد در هر جایی به یک باره حضور داشته باشد. سپس این توپ بر دره های کم عمق تر متمرکز شده و در نهایت می تواند به کم عمق ترین دره توسط تونل زنی از میان موانع برسد. این یعنی کامپیوتر D-Wave میتواند در کمترین زمان بهترین راه حل را برای مسائل پیشنهاد دهد.

نویز کوانتومی

یکی از اهداف اصلی آزمایشگاه، کار بر روی محاسبات کوانتومی “بی در رو” است. تیم تحقیقاتی تمایل بسیاری به درک این موضوع دارد که چگونه آثار نویزها، بی دقتی در ضرایب همیلتون (c) و فرآیندهای حرارتی، در دقت اندازه گیری و محاسبات کوانتومی “بی در رو” اثر می گذارند. برای مثال یکی از آزمایشات اصلی این گروه همان مثالی است که در تعریف محاسبات کوانتومی بی در رو یا Quantum Annealing آورده شد.

ضرایب همیلتون

ضرایب همیلتون در مکانیک کوانتومی ، به معنای مشاهده پذیری متناظر با انرژی کل سیستم است. مشاهده پذیر ، هر کمیتی است که به شیوه ای بتوان آن را اندازه گرفت.

مترولوژی کوانتومی

مترولوژی، علم اندازه گیری است که شامل استاندارد زمان و ساعت، اندازه گیری مسافت، جهت یابی و ناوبری، الکترو مغناظیس و کشف میدانهای گرانشی و تعیین ثابت های فیزیکی است. این تحقیقات در فیزیک اهمیت بسیار زیادی دارند، چرا که شامل بررسی این موضوع می شوند که ما دقیقا چگونه با طبیعت تعامل میکنیم. این موضوع برای ناسا هم اهمیت بسیار زیادی دارد. استفاده از مترولوژی کوانتومی به معنی بهبود و ارتقاء حسگرهای فضایی و بهبود ناوبری اینرشیال برای سفرهای فضایی آینده میباشد.

مترولوژی کوانتومی در رابطه با بهره بری از ارتباط کوانتومی Many-Body برای رسیدن به هدف افزایش حساسیت اندازه گیری نسبت به نمونه های کلاسیک آن است. حال برای داشتن حساسیت بیشتر نسبت به مدل های کلاسیک نیاز به طراحی مدل های کوانتومی است. تیم آزمایشگاه هوش مصنوعی ناسا در حال حاضر برای دستیابی به مدل های کوانتومی واقعی و به منظور رسیدن به چنین حساسیتی مشغول فعالیت است.

ثابت فیزیکی

ثابت فیزیکی یک کمیت فیزیکی است که در تمام جهان و در طول زمان تغییر نمی کند. ثابت های فیزیکی زیادی در جهان وجود دارد. مانند سرعت نور در خلاء که همیشه برابر ۴۵۸/۷۹۲/۲۹۹ متر بر ثانیه است.

سیستم ناوبری اینرشیال

سیستم ناوبری اینرشیال به نوعی یک سیستم هدایت کننده و مسیریاب است که از سنسورهای مینیاتوری مانند ژیروسکوپ و شتابسنج تشکیل شده است. در این شیوه فضاپیماها با حسگرهایی تجهیز می شوند که حرکت و شتاب فضاپیما را در جهات مختلف تحلیل می کنند. (نام این حسگرها ژیروسکوپ است). حال ژیروسکوپ ها میزان چرخش زاویه ای را اندازه گیری می کنند. هنگامی که ژیروسکوپ میزان حرکت زاویه ای را اندازه می گیرد، شتابسنج ها نیز حرکت در سه بردار اصلی را مشخص می کنند. تغییرات جهت ها برای داده پردازی به سیگنال هایی تبدیل می شود و این سیگنال ها به کامپیوتر مرکزی فرستاده می شوند. ادغام این اطلاعات، ژیروسکوپ و شتابسنج را سیستم ناوبری اینرشیال یا (INS) می گویند. این سیستم ناوبری از دو دستگاه برای چگونگی حرکت استفاده می کند و پس از داده پردازی، کامپیوتر مسیر صحیح و حتی موقیت و زمان فرود را به فضا پیما اطلاع می دهد.

Many-Body

نام یک گروه بزرگ از مشکلات فیزیکی است که مربوط به تعامل ذرات میکروسکوپی در مقیاس بسیار وسیع است.

کاربردهای بالقوه

ناسا در حال حاضر مشغول بررسی کاربردهای بالقوه ماشین های کوانتومی و بویژه الگوریتمهای Quantum Annealing است تا بتواند بسیاری از مشکلات محاسباتی خود را در مأموریت ها حل کند. یکی از اهداف اصلی این تیم، حل مشکلات محاسباتی برای مرکز تلسکوپ فضایی کپلر است که وظیفه آن پیدا کردن سیارات با ویژگی های زمین، جهت سکونت انسان است. حال کامپیوترهای کوانتومی با استفاده از شبیه سازی اطلاعات، توانایی انجام محاسبات بسیار پیچیده را جهت بدست آوردن اطلاعات دقیق این سیارات خواهند داشت. برای مثال چندی پیش این مرکـز سیاره Kepler-10B را کشف کرد و انجام محاسبات برای بدست آوردن ویژگی های دقیق این سیاره حدود یک سال طول کشید که با استفاده از الگوریتم های کوانتومی ، چنین محاسباتی سرعت و دقت بیشتری خواهند داشت.

همچنین از دیگر کاربردهای بالقوه این سیستم، می توان به کشف بهترین راه استفاده از منابع محدود در مأموریت های فضایی، مانند انرژی و زمان اشاره کرد. از مشکلات فعلی ناسا محاسبات مربوط به بهترین مسیریابی برای ربات Curiosity است که برای تحقیق در مورد وجود عناصر زیست محیطی به مریخ ارسال شده است.